AI Server: Yapay Zeka ile Çalışmak için Yüksek Performanslı GPU Sunucular

GPU Sunucular: AI (Yapay Zeka) ile En İyi Sonuçları Çıkarmanın Adresi

GPU server teknolojisi, geleneksel CPU (Central Processing Unit - Merkezi İşlem Birimi) tabanlı sunuculardan çok daha üstün paralel işlem kabiliyeti sunarak, yapay zeka uygulamalarının temelini oluşturuyor. AI server çözümlerimiz, karmaşık matematiksel hesaplamaları aynı anda binlerce çekirdek üzerinden gerçekleştirerek, derin öğrenme modellerinin eğitimini ve çıkarımını ciddi şekilde hızlandırıyor. Özellikle büyük veri setleri ile çalışan araştırma kuruluşları, teknoloji şirketleri ve üniversiteler için en iyi AI sunucu sistemlerimiz, projelerinin zaman çizelgesini aylardan günlere indirgeyen etkili çözümler sunuyor. Server AI teknolojimiz, sadece performans değil, aynı zamanda ölçeklenebilirlik ve güvenilirlik açısından da sektör standartlarını karşılayacak şekilde tasarlanmıştır.

AI Nedir? AI Server Hangi Çeşit Sunuculara Denir?

Yapay zeka (AI), insan benzeri düşünme, öğrenme ve karar verme yeteneklerini taklit eden bilgisayar sistemleridir. Bu sistemler, büyük miktarlardaki veriyi analiz ederek örüntüleri tespit etme, tahminler yapma ve karmaşık problemleri çözme kabiliyetine sahiptir. AI server ise, bu yapay zeka uygulamalarını çalıştırmak için özel olarak optimize edilmiş, yüksek performanslı GPU'larla donatılmış sunucu sistemleridir. Bu sunucular, geleneksel CPU sunuculardan farklı olarak, binlerce küçük işlemci çekirdeğini aynı anda kullanarak paralel hesaplama yapabilir. Server AI sistemlerimiz, makine öğrenmesi algoritmalarının eğitimi, derin öğrenme modellerinin çalıştırılması, büyük dil modellerinin işlenmesi ve gerçek zamanlı yapay zeka çıkarımları için optimize edilmiştir.

Yapay Zeka Uygulamaları için Neden GPU İhtiyacı Var?

CPU GPU farkı, yapay zeka uygulamalarında kritik bir performans farklılığı yaratır. Geleneksel CPU’lar (bilgisayarın beynini oluşturan ve karmaşık komutları işlemekten sorumlu olan ana işlemci), karmaşık işlemleri sıralı olarak gerçekleştirmek için tasarlanmışken, GPU’lar binlerce basit işlemi aynı anda paralel olarak gerçekleştirebilir. Bu GPU CPU farkı, özellikle yapay zeka uygulamalarında fark yaratıyor. AI algoritmalarının temeli olan matris çarpımları, konvolüsyon işlemleri ve gradyan hesaplamaları gibi matematiksel operasyonlar, doğası gereği paralel işleme uygun yapılardır.

Gpu ne işe yarar sorusunun cevabı da tam olarak burada yatıyor: GPU'lar, AI workload'larında CPU'lara göre 10-50 kat daha hızlı paralel hesaplama yapabilir. Bu oran, kullanılan AI modeli ve veri setine göre değişiklik gösterir. Basit bir örnekle açıklamak gerekirse, büyük veri setlerinin işlenmesinde GPU'lar, CPU'lara göre önemli zaman tasarrufu sağlar. Örneğin, derin öğrenme model eğitiminde haftalar sürebilecek işlemler, uygun GPU konfigürasyonu ile günlere indirgenebilir. Bu fark, işletmeler için ay yerine gün, gün yerine saat anlamına gelir. NVIDIA grafik kartlı sistemlerimiz, CUDA (Compute Unified Device Architecture - NVIDIA’nın paralel hesaplama platformu ve programlama modeli) çekirdekleri sayesinde binlerce küçük hesaplamayı eş zamanlı olarak işleyerek AI projelerinizin verimliliğini maksimuma çıkarır.

AI Server Ne Gibi Uygulamalar için Gereklidir?

AI GPU teknolojisinin uygulama alanları günden güne genişliyor ve neredeyse her sektörden işletme bu teknolojiden faydalanabiliyor. Derin öğrenme ve Neural Networks ( Sinir Ağları) eğitimleri, en yaygın kullanım alanlarından biridir. Görüntü tanıma, doğal dil işleme, konuşma tanıma ve üretken AI modelleri gibi uygulamalar, yoğun GPU hesaplama gücü gerektirir. Yapay zeka sunucu sistemlerimiz, ayrıca otonom araç teknolojileri, medikal görüntü analizi, finansal risk analizi, siber güvenlik anomali tespiti ve büyük veri analizi projelerinde de kritik rol oynar. AI server çözümlerimizin başlıca kullanım alanları arasında araştırma kurumları için bilimsel simülasyonlar, ilaç çalışmaları, genetik analiz ve iklim modelleme gibi hesaplama yoğun projeler yer alır. E-ticaret şirketleri öneri sistemleri, sosyal medya platformları içerik filtreleme ve oyun endüstrisi grafik işleme süreçlerinde de yapay zeka sunucu donanımları oldukça önemlidir.

GPU Sunucu Çeşitleri

Farklı AI projenizin ihtiyaçlarına uygun olarak çeşitli GPU server konfigürasyonları sunuyoruz. Entry-level AI sunucuları, küçük ölçekli machine learning projeleri ve prototip geliştirme için idealdir. Bu sistemler genellikle 1-2 adet orta sınıf GPU ile donatılmıştır. Mid-range (orta-seviye) yapay zeka sunucu sistemlerimiz, kurumsal AI uygulamaları ve orta ölçekli deep learning projeleri için tasarlanmış olup, 4-8 adet yüksek performanslı GPU barındırır. Enterprise-level (kurumsal seviye) server gpu çözümlerimiz ise, NVIDIA DGX benzeri sistemleri, 8-16 adet en üst seviye GPU içerir. Bunlar büyük ölçekli AI araştırmaları için optimize edilmiştir. Özel olarak tasarladığımız ekran kartlı sunucu sistemlerimiz, sizin özel ihtiyaçlarına göre konfigüre edilebilir ve farklı GPU markalarını (NVIDIA, AMD) destekleyebilir. En iyi AI sunucu çözümlerimiz arasında yer alan bu sistemler, VRAM (Video Random Access Memory - Video Bellek) kapasiteleri ve CUDA çekirdek sayıları açısından da farklılaşır. Ayrıca NVIDIA B300, B200, H200, A100, H100, RTX 5090, RTX PRO 6000, RTX 6000 Ada gibi farklı GPU modellerini ve AMD Instinct serisi (örneğin MI300X) çözümlerini içeren çözümlerimizle, her bütçe ve performans ihtiyacına cevap veriyoruz. Türkiye'deki AI girişimcileri için özel çözümler sunarak, yerli teknoloji ekosisteminin gelişimine katkıda bulunuyoruz.

NVIDIA GPU Karşılaştırmalı Tablo

Enterprise ve Data Center GPU'ları

| Model | VRAM | CUDA Çekirdekleri | Tensor Çekirdekleri | TDP | Bellek Bant Genişliği |

| H100 SXM | 80GB HBM3 | 16.896 | 528 (4. Nesil) | 700W | 3,35 TB/s |

| H100 PCIe | 80GB HBM2e | 14.592 | 456 (4. Nesil) | 350W | 2,0 TB/s |

Uygulama Alanları:

- Large Language Models

- Enterprise AI Eğitimi

NVIDIA A100 Serisi

| Model | VRAM | CUDA Çekirdekleri | Tensor Çekirdekleri | TDP | Bellek Bant Genişliği |

| HGX B300 | 288 GB HBM3e | 37.888 | 1.184 (5. Nesil) | 1400W | 8,2 TB/s |

| HGX B200 | 180 GB HBM3e | 37.888 | 1.184 (5. Nesil) | 1000W | 8,2 TB/s |

| H200 SXM | 141 GB HBM3e | 16.896 | 528 (4. Nesil) | 700W | 4,89 TB/s |

| H200 NVL PCIe | 141 GB HBM3e | 16.896 | 528 (4. Nesil) | 600W | 4,89 TB/s |

| A100 SXM | 80GB HBM2e | 6.912 | 432 (3. Nesil) | 400W | 2,0 TB/s |

| A100 PCIe | 80GB HBM2e | 6.912 | 432 (3. Nesil) | 300W | 1,9 TB/s |

Uygulama Alanları:

- Server AI

- Enterprise AI Eğitimi

NVIDIA L40S

| Spesifikasyon | Değer |

| VRAM | 48GDDR6 |

| CUDA Çekirdekleri | 18.176 |

| Tensor Çekirdekleri | 568 (4. Nesil) |

| Bellek Bant Genişliği | 864 GB/s |

| TDP | 350W |

Uygulama Alanları:

- Multi-modal AI

- Grafik

- AI Inference

Professional Workstation GPU'ları

| Spesifikasyon | NVIDIA RTX PRO 6000 | NVIDIA RTX 6000 Ada Generation |

| VRAM | 96GDDR7 | 48GDDR6 |

| CUDA Çekirdekleri | 24.760 | 18.176 |

| Tensor Çekirdekleri | 752 (5. Nesil) | 568 (4. Nesil) |

| Bellek Bant Genişliği | 1,79 TB/s | 960 GB/s |

| TDP | 600W | 300W |

Uygulama Alanları:

- Profesyonel AI

- CAD

- İçerik Üretimi

NVIDIA RTX A6000

| Spesifikasyon | Değer |

| VRAM | 48GDDR6 |

| CUDA Çekirdekleri | 10.752 |

| Tensor Çekirdekleri | 336 (2. Nesil) |

| Bellek Bant Genişliği | 768 GB/s |

| TDP | 300W |

Uygulama Alanları:

- Profesyonel Grafik

- AI Geliştirme

NVIDIA RTX 4090

| Spesifikasyon | Değer |

| VRAM | 24GDDR6X |

| CUDA Çekirdekleri | 16.384 |

| Tensor Çekirdekleri | 512 (4. Nesil) |

| Bellek Bant Genişliği | 1,008 GB/s |

| TDP | 450W |

Uygulama Alanları:

- AI Geliştirme

- High-End Gaming

AI Performans Karşılaştırması

Training Performansı (FP16 Tensor)

| GPU Modeli | TFLOPS | Önerilen Model Boyutu |

| H100 | 3.958 | 175B+ Parametre |

| A100 | 1.248 | 70B-175B Parametre |

| L40S | 1.466 | 30B-70B Parametre |

| RTX 6000 Ada | 1.320 | 13B-30B Parametre |

| RTX 4090 | 1.320 | 7B-13B Parametre |

Inference Performansı

| GPU Modeli | TOPS | Uygulama Alanı |

| H100 | 3.958 | Production LLM |

| A100 | 624 | Enterprise Inference |

| L40S | 733 | Multi-modal AI |

| RTX 6000 Ada | 660 | Profesyonel AI |

| RTX 4090 | 660 | Geliştirme/Araştırma |

| Uygulama Alanı | Önerilen GPU'lar | Minimum VRAM | Cluster Gereksinimi | Örnek Uygulamalar |

| Large Language Models (LLM) | H100, A100 | 80 GB | 4-8 GPU | GPT, BERT, T5, LLaMA |

| Computer Vision | RTX 6000 Ada, L40S, RTX 4090 | 24 GB | 1-4 GPU | Nesne Tespiti (Object Detection), Görüntü Segmentasyonu (Image Segmentation), Tıbbi Görüntüleme (Medical Imaging) |

| Natural Language Processing (NLP) | A100, RTX 6000 Ada | 48 GB | 2-4 GPU | Duygu Analizi (Sentiment Analysis), Çeviri (Translation), Metin Sınıflandırma (Text Classification) |

| AI Inference (Üretim Ortamı) | L40S, RTX 4090 | 16 GB | 1-2 GPU | Gerçek Zamanlı AI Servisleri, Edge AI |

| Segment Adı | Bütçe Aralığı | Önerilen GPU'lar | Temel Kullanım Alanı | Performans Beklentisi |

| Entry Level AI | $5.000 - $15.000 | RTX 4090, RTX 4080 | AI öğrenme, Prototipleme | Orta seviye eğitim (training), Hızlı çıkarım (inference) |

| Professional AI | $15.000 - $50.000 | RTX 6000 Ada, L40S | Profesyonel geliştirme, Ciddi projeler | Yüksek performanslı eğitim (training) |

| Enterprise AI | $50.000+ | A100, H100 | Büyük ölçekli ve kritik projeler | Üretime hazır (Production-ready), En yüksek performans |

NVIDIA DGX Alternatifleri

NVIDIA DGX sistemlerinin yanı sıra, farklı bütçe ve performans gereksinimlerine uygun alternatif AI server çözümleri de sunuyoruz. Bu alternatifler, DGX sistemlerinin sunduğu yüksek performansı daha uygun maliyetlerle elde etmenizi sağlar.

Supermicro AI Sunucular: Supermicro’nun GPU-optimized server sistemleri, modüler tasarımları ve yüksek yoğunluklu GPU konfigürasyonları ile öne çıkar. Supermicro SYS-420GP-TNAR ve SYS-740GP-TNRT gibi modeller, 8 adet NVIDIA H100 veya A100 GPU’yu destekleyerek DGX A100’e alternatif oluşturur. Bu sistemler, özellikle büyük ölçekli AI eğitim projeleri için maliyet-performans dengesinde üstün çözümler sunar.

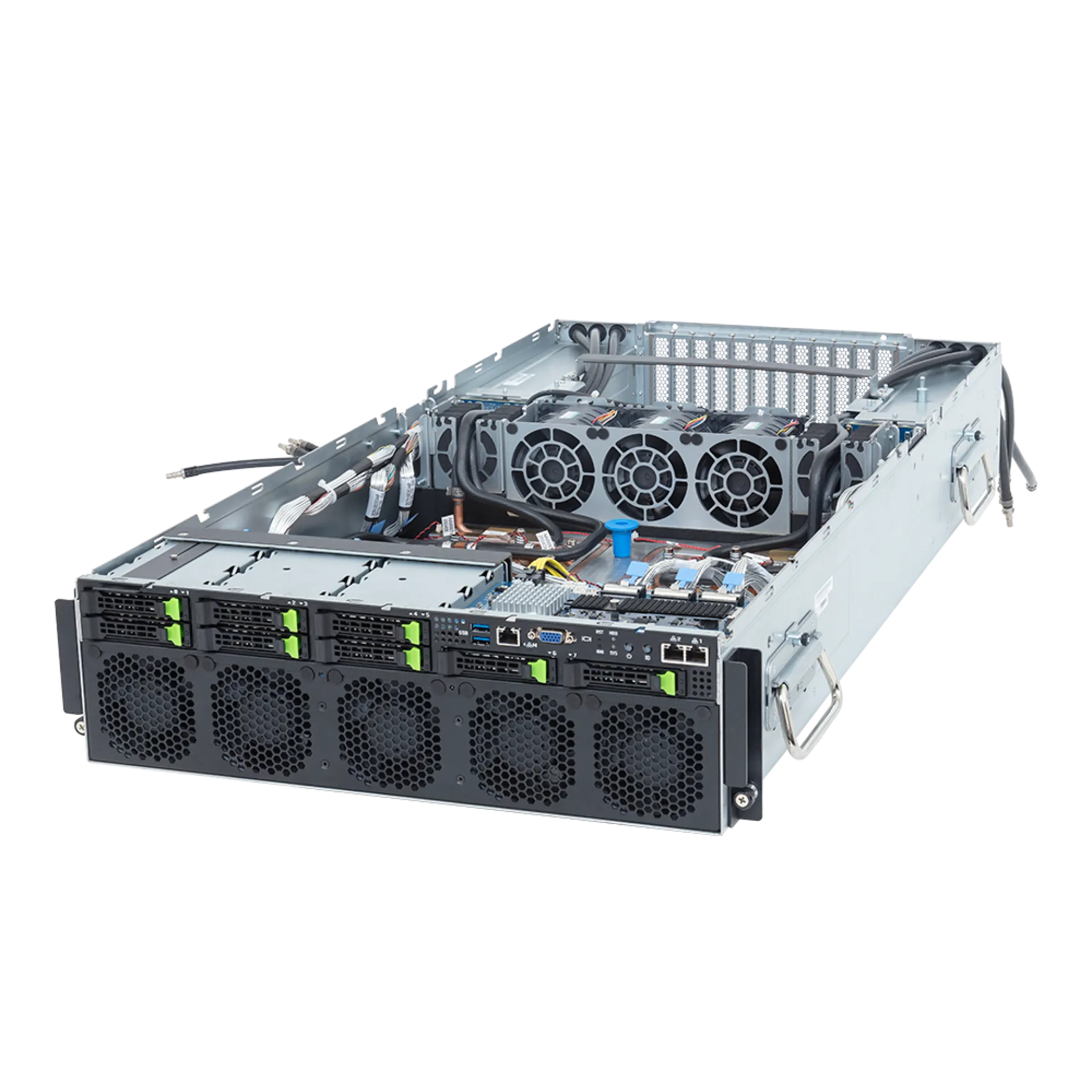

Gigabyte AI Sunucular: Gigabyte’ın G-Series AI sunucuları, kompakt tasarımları ve güçlü soğutma sistemleri ile dikkat çeker. G292-Z40, G482-Z50 ve G292-Z20 gibi modeller, 4-10 adet GPU desteği ile orta ve büyük ölçekli AI projelerine uygun çözümler sunar. Gigabyte sistemleri, özellikle araştırma kurumları ve üniversiteler için ideal ortamı sağlar.

Dell AI Sunucular: Dell PowerEdge serisi AI sunucuları, kurumsal güvenilirlik ve kapsamlı destek hizmetleri ile tercih edilir. PowerEdge XE8545, PowerEdge R750xa ve PowerEdge C6525 gibi modeller, 2-4 adet GPU desteği ile entry-level ve mid-range AI projelerine odaklanır. Dell sistemleri, özellikle kurumsal ortamlarda tercih edilen güvenilir AI server alternatifleri olarak görülür.

Bu alternatif çözümler, NVIDIA DGX sistemlerinin %30-50 daha uygun maliyetlerle benzer performans sunarak, AI projelerinizin bütçe gereksinimlerine uygun seçenekler sağlar. Her marka için özel konfigürasyon ve destek hizmetlerimizle, size en uygun AI server çözümünü belirlemenizde yardımcı oluyoruz.

AI Server Performansını Ölçerken Nelere Dikkat Edilmeli?

AI server performansını değerlendirirken GPU sayısı ve modeli kadar, sistem mimarisinin bütünsel performansı da büyük önem taşır. İlk olarak, GPU bellek kapasitesi (VRAM) önemli bir faktördür; büyük modeller için en az 24GB VRAM öneriyoruz. İkinci olarak, GPU'lar arası bağlantı hızı (NVLink, InfiniBand) paralel hesaplamalarda darboğaz yaratmaması için yeterli olmalıdır. Sistem belleği (RAM) de GPU'larla orantılı olmalı; genellikle GPU başına 64-128GB RAM öneriyoruz. Depolama alt sisteminde NVMe SSD'ler, büyük veri setlerinin hızlı transferi için gereklidir. CPU performansı da ihmal edilmemelidir; AI iş yüklerini destekleyecek yeterli çekirdek sayısı ve yüksek bellek bant genişliği kritiktir. Soğutma sistemi, yüksek performanslı GPU'ların sürekli çalışması için optimize edilmelidir. Güç altyapısı da 7/24 çalışma için yeterli kapasitede ve redundant olmalıdır. Son olarak, yapay zeka sunucu donanımları seçiminde, kullanılacak AI framework'leri (TensorFlow, PyTorch, CUDA) ile uyumluluk da kontrol edilmelidir.

GPU Server Satış Hizmetimizin Kapsamı: Neden Happyware?

Happyware olarak AI server ve GPU sunucu alanında size sadece bir ürün değil, kapsamlı bir çözüm ve güvenilir bir ortaklık sunuyoruz. Yapay zeka projeleriniz bir yatırımdır ve biz bu yatırımın karşılığını en iyi şekilde vermek için çalışıyoruz.

İşte Happyware'i AI server pazarında rakiplerinden ayıran avantajlar:

- Sektörde 25 Yılı Aşkın Tecrübe: Çeyrek asrı deviren deneyimimizle, sunucu teknolojilerindeki derin bilgimizi ve AI server pazarındaki uzmanlığımızı sizinle paylaşıyoruz. GPU sunucu ihtiyaçlarınızı doğru analiz ederek size en uygun çözümleri sunuyoruz.

- 10 Yıla Yakın GPU Server Deneyimi: NVIDIA, Supermicro, Gigabyte gibi GPU ve server üreticileri ile doğrudan çalışma deneyimimiz, AI server alanında derin uzmanlığımızın garantisidir. Bu deneyim, en güncel AI teknolojilerini takip etmemizi ve size en iyi çözümleri sunmamızı sağlar.

- Almanya'da ISO9001 Kalite Sertifikalı Üretim ve Yönetim: Tüm Happyware markalı AI server sistemleri, Almanya'daki tesislerimizde, uluslararası kabul görmüş ISO9001 kalite yönetim standartlarına uygun olarak üretilir ve yönetilir.

- En Yüksek Kalite ve Güvenilirlik: Kullandığımız her GPU ve sistem bileşeninde kalite ve güvenilirliği ön planda tutuyoruz. GPU sunucu sistemlerimiz, 7/24 kesintisiz AI iş yükleri için tasarlanmıştır.

- 100.000'i Aşkın Server Üretim ve Teslimatı: Bugüne kadar 100.000'den fazla server sistemi üretip, dünyanın dört bir yanındaki müşterilerimize ulaştırmanın gururunu yaşıyoruz. Bu deneyim, AI server projelerinizde size güvence verir.

- Tamamen Müşteriye Özel AI Server Üretimi: Standart GPU sunucu çözümlerinin yetersiz kaldığı durumlarda, AI projelerinizin gereksinimleri doğrultusunda, tamamen size özel yapay zeka sunucu sistemleri tasarlayıp üretiyoruz.

- Hızlı Teslimat İçin Özel Portföy: AI projelerinde zamanın değerinin farkındayız. Popüler GPU modelleri ve AI server konfigürasyonları için oluşturduğumuz özel portföyümüz sayesinde, siparişlerinizi hızla teslim edebiliyoruz.

- 6 Yıla Kadar Garanti Süreci: AI server yatırımınıza duyduğumuz güvenin bir yansıması olarak, standart garantinin ötesinde, 6 yıla kadar uzatılabilen garanti seçenekleri sunuyoruz.

- Türkiye'nin Her Bölgesinde Yerinde Servis Hizmeti: AI projelerinizde kesintisizliğin kritik önemini anlıyoruz. Bu nedenle, Türkiye'nin her köşesinde GPU sunucu sistemleriniz için yerinde servis hizmeti sağlıyoruz.

- Server Üreticileri ile Doğrudan Ortaklıklar: NVIDIA, Supermicro ve Gigabyte gibi lider GPU ve server üreticileriyle yaptığımız doğrudan ortaklıklar sayesinde, en yeni AI teknolojilerine ve en rekabetçi GPU server fiyatlarına erişim sunuyoruz.

- 7/24 Uzman Desteği: AI projelerinizde sorun yaşamamanız için, haftanın 7 günü, günün 24 saati uzman teknik destek ekibimizle AI server konularında destek sağlıyoruz.

- Kişisel Danışmanlık ve Proje Desteği: Her AI projesi farklıdır. Bu nedenle, projenizin her aşamasında size kişisel danışmanlık hizmeti sunuyoruz. İhtiyaçlarınızın doğru tespitinden en uygun GPU server konfigürasyonunun belirlenmesine kadar her adımda yanınızdayız.

- Yerli Teknoloji Projelerine Destek: Yerli teknoloji projelerinizi destekliyoruz. Türkiye'nin teknoloji bağımsızlığına katkıda bulunmak için yerli AI girişimlerine özel fiyatlandırma ve danışmanlık hizmetleri sunuyoruz.

NVIDIA GPU sunucu çözümlerimizle yapay zeka projelerinizin potansiyelini maksimuma çıkarın. Projenizin ölçeği ne olursa olsun; fikir aşamasından uygulamaya ve sonrasına kadar, size özel atanmış bir danışmanla kişisel destek sağlıyoruz. En uygun AI server fiyatları ve en iyi AI sunucu konfigürasyonlarıyla yanınızdayız.